10 Logistic Regression

介绍Logistic Regression算法,见详细课件。

Formulation

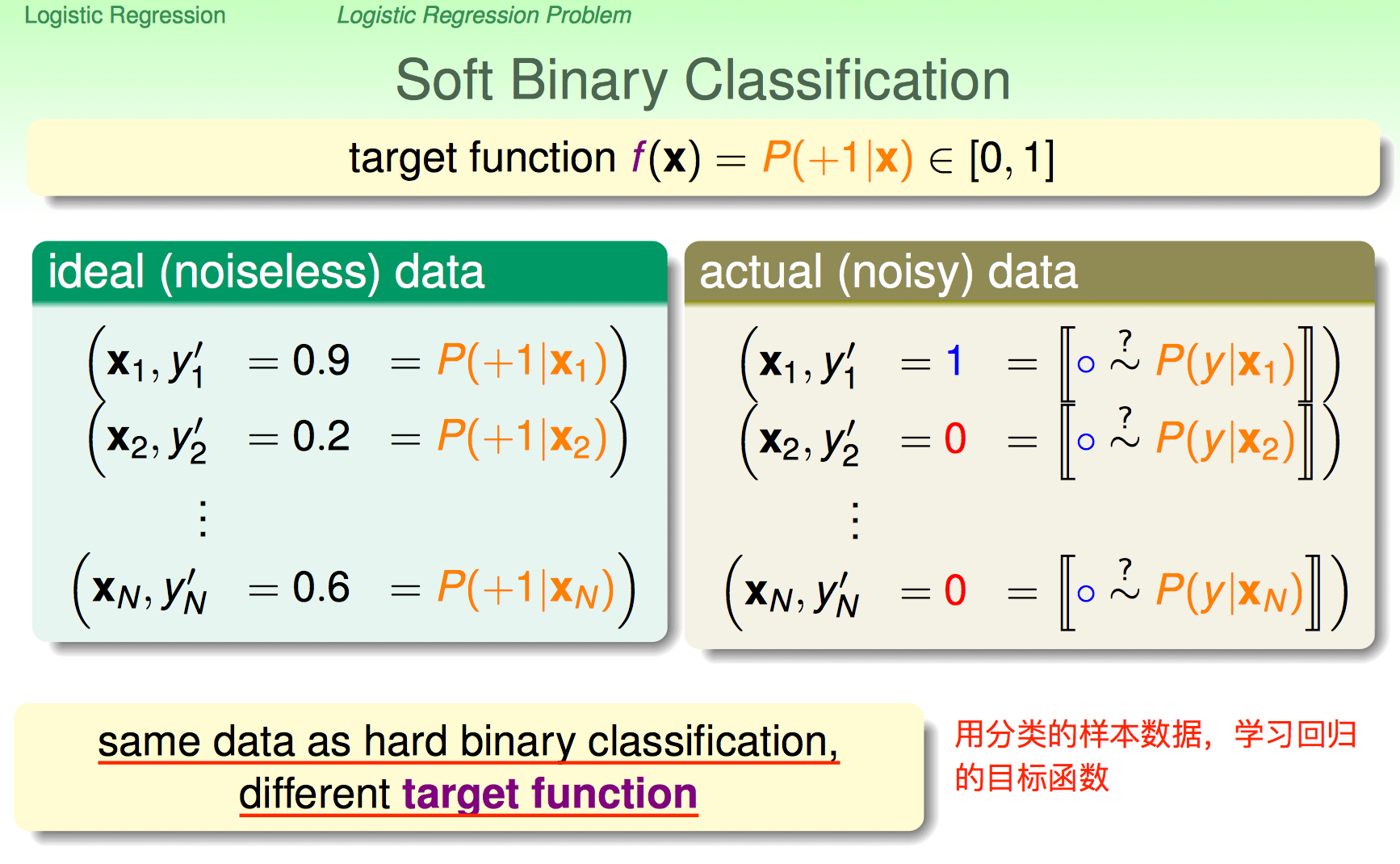

从分类(离散的)样本数据中学习这样一个目标函数

注意是概率(连续的)。相当于用分类的数据,学习回归函数。

摘自教材《Learing From Data》

Formally, we are trying to learn the target function

The data does not give us the value of $f$ explicitly. Rather, it gives us samples generated by this probability, e.g., patients who had heart attacks and patients who didn’t. Therefore, the data is in fact generated by a noisy target distribution.

问题可以抽象为,对输入

计算其weight score,与PLA和Linear Regression一样

然后经过logistic function将其转化为概率。简言之,逻辑回归就是用

来学习target distribution

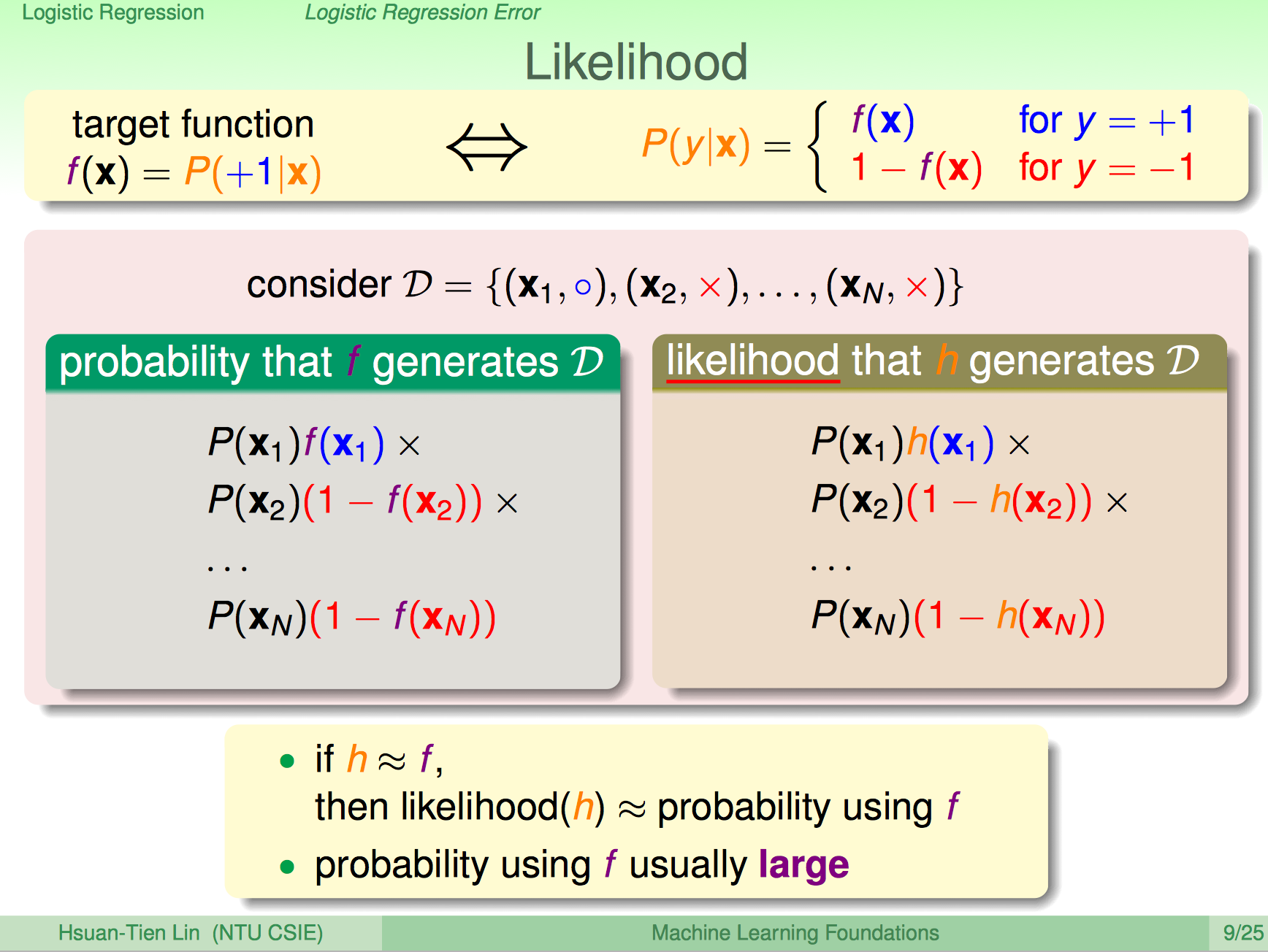

Likelihood

逻辑回归的Error Measure基于最经典likelihood的概念。即假设分布式是

那当前样本集的likelihood为

使其最大化,对应的参数即我们期望的解。根据sigmoid函数性质(见附录),我们的假设分布可简化为(极其重要)

将问题转化为求最小值(误差最小思路)

得到优化目标为

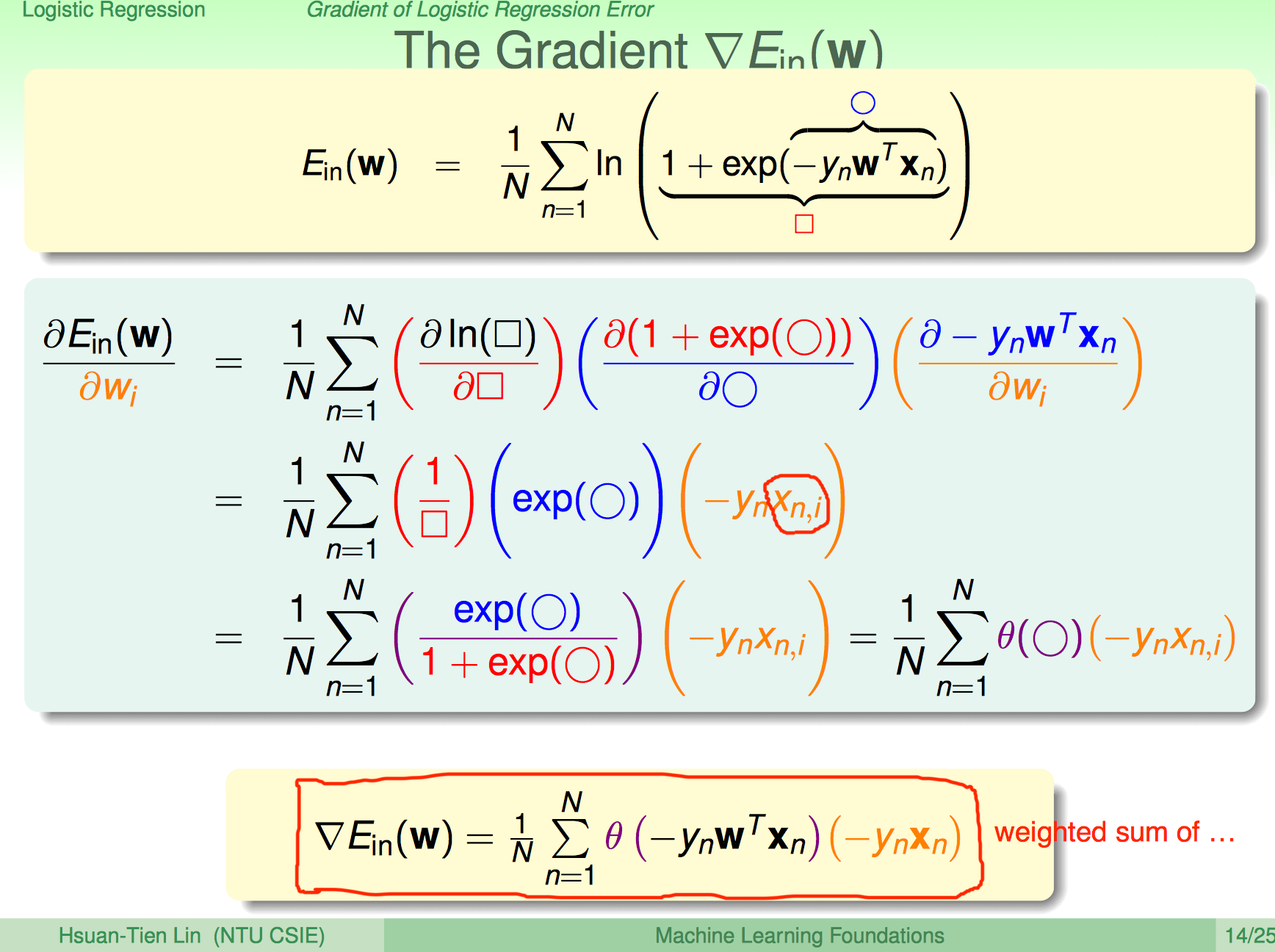

可以看出,误差函数跟交叉熵(见附录)是等价的。得到误差函数之后,对其求导,即可用梯度下降或随机梯度下降求导。

附录

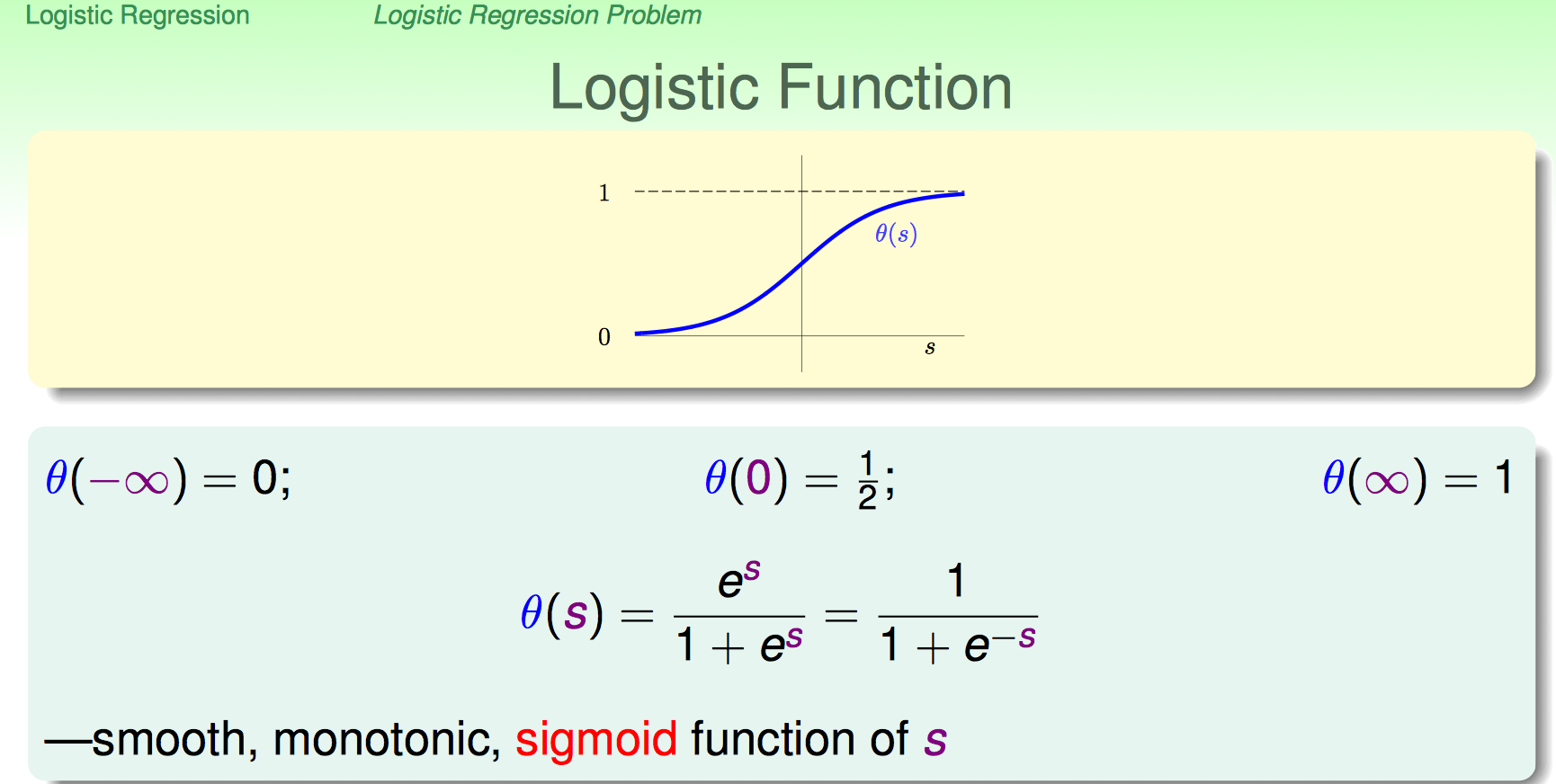

Sigmoid

从图中对称性不难得出

对其求导

与tanh函数关系(通过取值区间猜想)

其中

交叉熵

两个概率分布${p,1-p}$以及${q,1-q}$,其交叉熵为: